O Intel Developers Forum da Califórnia, EUA, este ano aconteceu de 19 a 21 de agosto, como sempre no Moscone Center de San Francisco. De acordo com a estratégia “tic-toc” da Intel, que consiste em lançar as inovações em um ano e trazer os produtos ao mercado no ano seguinte, este não foi um ano de novidades. Houve, sim, a apresentação dos primeiros membros da família Nehalem, o core i7 de quatro núcleos, já em processo de fabricação e disponível dentro de alguns dias (veja, na figura, o “wafer” apresentado na palestra de abertura e repare como foi difícil arrumar um ângulo decente para fazer a foto...) e muito papo sobre os membros da família Atom, os sucessores da falecida linha XScale para dispositivos móveis. Dispositivos estes que, agora com o irrecusável apelo da Internet (MID, “Mobile Internet Devices”, ou “dispositivos móveis para a Internet”), tornaram-se o centro das atenções do evento. Falou-se muito também dos SSD (“Solid State Disks”, ou discos de estado sólido) que, diferente do que o nome indica, não são discos mas sim parrudíssimos dispositivos de armazenamento de massa destinados a substituir justamente os discos magnéticos. Fabricados com memória tipo “flash” como os populares “pen drives” mas de capacidade muitíssimo maior (este ano a Intel lança um dispositivo de armazenamento de massa de memória “flash” com capacidade de 80 GB e espera-se o modelo de 160 GB para o início do ano que vem), esses bichinhos são dezenas de vezes mais rápidos que os discos magnéticos, muito menores que eles mas, por enquanto, muitíssimo mais caros. Porém, se a tendência de redução de preços com a massificação das vendas não falhar (e não há razão para que falhe), tivera eu meu dinheiro investido (isso, bem entendido, se eu tivesse dinheiro para investir...) na indústria de discos magnéticos, começaria a me preocupar seriamente com o futuro.

|

Figura 1: o “wafer” do Nehalem e o Piropo se espremendo para conseguir uma foto |

Mas tratar destes assuntos é coisa para profissional, e Mestre Xandó, que também lá estava abrilhantando o evento, já os abordou (e prometeu continuar escrevendo sobre) em sua coluna “IDF 2008 – A Intel mudou!”. E não sou eu que vou me meter a besta de escrever sobre o mesmo tema que ele. Então, cabe a mim compartilhar com vocês minhas inquietações sobre um negócio que foi badaladíssimo pela Intel neste IDF e que, sei lá, ficou assim meio que no ar, como se estivesse faltando alguma coisa. O assunto é “CVC”, de “Connected Visual Computing” (computação visual conectada) e seu inevitável desdobramento: a arquitetura Larrabee.

Então vamos lá. Começando por tentar explicar o que a Intel classifica como “Visual Computing”.

O IDF dura, oficialmente, três dias, de terça à quinta-feira. Porém, efetivamente, começa um dia antes, segunda-feira, apelidada de “dia zero”. Neste dia a Intel reúne um grupo de representantes da imprensa internacional e seletos convidados para abordar aquilo que ela considera os pontos de maior interesse do evento. E a tarde do “dia zero” foi dedicada à uma apresentação de Jim Held, Intel Fellow e diretor de pesquisas de computação em tera-escala da empresa, abordando justamente o tema da computação visual conectada.

Nela, Held lembrou que a Internet não somente tornou-se cada vez mais interativa, evoluindo rapidamente desde as primeiras redes sociais, tipo Orkut e, recentemente, MySpace, como também tem recebido cada vez mais conteúdo gerado pelos próprios usuários e se beneficiado das conexões rápidas (“banda larga”) e computação móvel. O próximo passo, segundo ele, é a computação visual conectada.

Mas que diabo é isto?

Segundo Held, nos tempos pioneiros o foco primário da computação abrangia apenas números e texto. E quem, como eu, usou um velho XT com monitor de fósforo verde cujos aplicativos exploravam quase exclusivamente o “modo texto” do vídeo monocromático, entendeu perfeitamente o que ele quis dizer. Já nos computadores modernos a coisa é diferente: eles geram representações digitais altamente complexas do mundo que nos rodeia usando modelos tridimensionais, vídeo de alta definição e outros tipos de representações gráficas sofisticadíssimas. Que não são usadas apenas nos ambientes de jogos, onde são criadas representações de florestas tão vívidas que se pode observar detalhes de folhas de samambaias e distinguir o reflexo de um raio luminoso nas costas de um réptil iridescente, mas também em aplicativos gráficos usados em arquitetura e urbanismo, que podem representar a aparência futura de bairros inteiros remodelados com detalhes extremamente realísticos e em programas usados na área de saúde nos quais, por exemplo, pode-se representar um modelo intrincado do coração de um paciente, batendo, em tempo real, com detalhes cirurgicamente precisos.

Este tipo de tarefas computacionais exige novas arquiteturas capazes de recorrer não apenas ao processamento avançado de dados visuais como também ao manejo de grandes quantidades de dados convencionais, posto que a aquisição dos dados, sua análise, modelagem e, finalmente, sua síntese em imagens digitalizadas deve ser feita de forma suave e transparente ao usuário.

Figura 2: ilustração da CVC

|

Figura 1: o “wafer” do Nehalem e o Piropo se espremendo para conseguir uma foto |

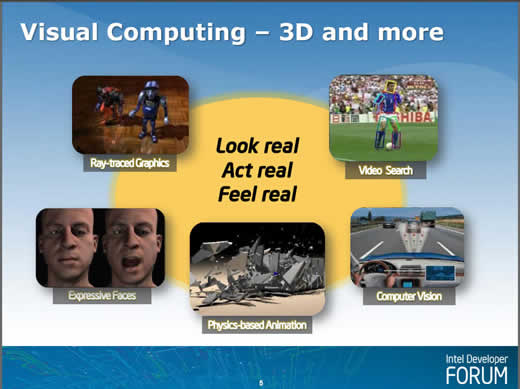

Pois bem: segundo Held, CVC é a tecnologia da Intel que permite que dados visuais sejam processados e exibidos para satisfazer às demandas acima. A Figura 2, uma das ilustrações exibidas em sua palestra, mostra algumas delas. No sentido horário, e começando do canto superior esquerdo: imagens hiper-realistas criadas usando a técnica “Ray tracing” (na qual são calculadas as trajetórias de raios luminosos no plano da imagem e se percebe o reflexo de elementos dentro da própria imagem), localização de pontos de interesse de uma imagem para facilitar a modelagem, capacidade de dispositivos embarcados em veículos de “ver” detalhes que poderiam escapar aos olhos humanos (como o fato de se haver atingido a distância de segurança entre dois veículos, fazendo com que o veículo que está a ponto de provocar um acidente desacelere automaticamente), animações baseadas nas leis físicas que regulam as variações do movimento de corpos de massa conhecida e a possibilidade de criação por usuários comuns de imagens tridimensionais de rostos expressivos (se bem que a expressão daquele carinha da direita me parece um tanto abestalhada, mas há que levar em conta que a tecnologia está ainda em seus estágios iniciais).

Pois bem: leve esta capacidade computacional gráfica para os tão falados MIDs (dispositivos móveis conectados à Internet) que você terá o CVC que, segundo Held, consubstanciará o próximo estágio da Internet, sucedendo à “Web 2.0”.

Mas porque imagens realistas seriam tão importantes para a Internet?

Bem, diz Held que basta acompanhar a tendência dos chamados “mundos virtuais”, tipo Second Life e companhia, para entender. Há cerca de um ano, em maio de 2007, estes sítios reuniam cerca de sessenta milhões de usuários. Pouco mais de um ano depois disso, em junho deste ano, eles chegavam a mais de trezentos milhões. Hoje, já existem mais de dois mil mundos virtuais nos quais, apenas em 2007, foram investidos mais de um bilhão de dólares e cuja maioria dos usuários tem menos de doze anos de idade. O que, segundo Held, permite concluir que eles atingirão a marca de um bilhão em dez anos. Ou seja: dentro de uma década os mundos virtuais replicarão pouco menos de um quinto da população do planeta.

E mundos virtuais são, sobretudo, visuais.

|

Figura 3: aplicações da CVC |

Mas não é só isso. Repare na Figura 3, também obtida da apresentação de Held. Na esquerda se vê um “mapa híbrido”, ou seja: a superposição do traçado de uma trilha nas montanhas em uma imagem real da região. Sim, eu sei que o Google Maps já faz isso, mas repare melhor na foto: trata-se de um dispositivo portátil, conectado à Internet, e o trecho da imagem que se vê à esquerda, mostrando o detalhe da trilha, é gerado em tempo real por uma câmara de vídeo.

Perceba, imediatamente ao lado, um MID com uma câmara de vídeo mostrando a imagem amplificada de um pequeno inseto. Trata-se do “Bicudo-do-algodoeiro” (Anthonomus grandis), um artrópode que mede menos de seis milímetros mas que nem por isso deixa de ser uma enorme praga que causou prejuízos imensos às culturas de algodão de um continente inteiro. Originário do México, espalhou-se pelas Américas do Norte, Central e do Sul e devastou a economia da indústria algodoeira. Note que seu nome (em inglês: “Boll weevil”) aparece junto à imagem. Isto porque a imagem capturada pelo MID foi enviada a um banco de dados gráficos remoto que identificou o espécime e retornou suas características ao MID. Já imaginaram a importância de um negócio desses nas mãos de um entomologista ou pesquisador agrícola?

Repare na figura seguinte. Ela mostra uma vista superior de um automóvel com um capô aberto onde se vê, à esquerda, uma chave de fenda apontada para um parafuso e, acima, em inglês, a instrução “afrouxe dois parafusos”. Trata-se de um manual de instruções. Mas um manual de instruções muito especial: não apenas acessado remotamente como também animado. Porque a imagem é a da tela de um MID que descreve, passo a passo e com animações, o procedimento para efetuar um pequeno reparo no veículo. Agora pense: já imaginou o quanto isto pode ser útil para um pobre motorista perdido em um local remoto (não se preocupe: logo logo os MIDs terão acesso à Internet mesmo em locais remotos) cujo carro “enguiçou” e que pode ser consertado por ele mesmo, desde que saiba como proceder? Vale uma vida...

A última, talvez, seja a mais ilustrativa. Pense no pobre oriental perdido em plena Walnut Street (ora, pensando bem ele até que não está em uma situação tão aflitiva... Mas seja como for: ) sem ter a menor idéia de onde se encontra. Pois bem: basta que ele aponte a lente de seu MID para a placa da esquina que a imagem será enviada pela Internet a um servidor regional e o nome da rua, em seu idioma nativo, aparecerá prontamente.

|

Figura 4: criação de uma face expressiva tridimensional |

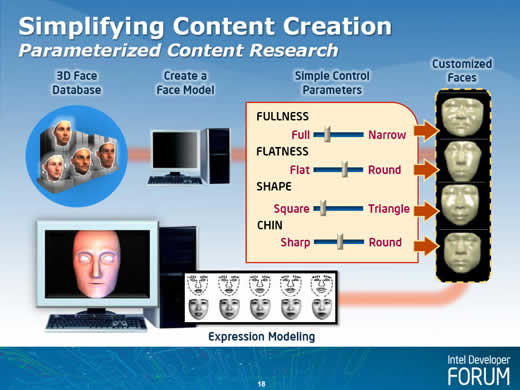

Finalmente, mais um exemplo interessante. Digamos que você pretenda criar um personagem para representá-lo em um dos muitos mundos virtuais ao qual pertence. Será seu avatar, mas um avatar tridimensional, animado e expressivo. Repare na Figura 4, também da apresentação de Jim Held: basta entrar em um banco de dados de faces em 3D, escolher uma, criar um modelo alterando suas características usando funções de um programeto acionadas com controles deslizantes, recorrer a um “modelador de expressões” e, voilá, eis aí sua expressiva representação. E isso sem qualquer conhecimento de animação, projeto gráfico e, evidentemente, sem qualquer talento artístico. Simpático, nénão?

Pois para ter acesso a tudo isto há que cumprir um bocado de condições.

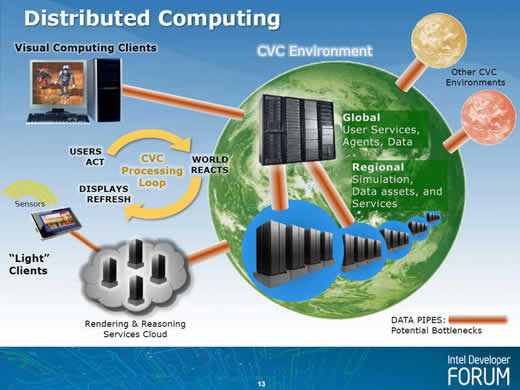

A primeira é que um “ambiente CVC” exige não apenas um bocado de poder computacional como também – e sobretudo – uma disseminação quase universal de acesso à Internet em taxas elevadíssimas e praticamente em qualquer local que se esteja. Veja, na Figura 5, também da apresentação de Held, como a coisa deveria funcionar.

|

Figura 5: modelo de computação distribuída para um ambiente CVC |

Seria um ambiente de computação distribuída onde clientes, que tanto podem ser dispositivos de mesa como dispositivos móveis – estes últimos ligados a uma “nuvem” de servidores – enviariam as ações de cada usuário a um núcleo global que, por sua vez, após consultar bancos de dados que eventualmente poderão estar espalhados em diversos núcleos regionais, enviariam suas respostas (ou reações) de volta aos clientes, que então as exibiriam na tela em modo gráfico. Esses “ambientes” poderão se conectar a outros ambientes similares com os quais trocarão dados.

Note, na figura, que justamente o transporte de dados entre estes elementos, ou “data pipes”, estão assinalados como potenciais gargalos (“bottlenecks”) de todo o conjunto, o que significa que, do ponto de vista da Intel, o elo mais fraco da corrente ainda é a transmissão de dados.

Mas e o poder computacional? E a capacidade gráfica?

Bem, pelo que eu pude perceber no IDF, este problema a Intel pretende resolver com a arquitetura Larrabee.

Nosso próximo assunto, naturalmente.

B.

Piropo